Verification Bottleneck: Vấn đề thật của AI Code 2026

48% AI code chứa vulnerabilities. Verification Bottleneck là gì và 5 giải pháp review AI code hiệu quả cho developers.

Hôm nay tôi đọc được danh sách 10 Breakthrough Technologies 2026 của MIT Technology Review, và Generative Coding đứng ngay vị trí đầu tiên. Satya Nadella claim 30% code Microsoft là AI viết. Sundar Pichai cũng khoe con số tương tự ở Google. Zuckerberg thì đặt target 50% cho Meta năm tới.

Nghe impressive lắm, đúng không?

Nhưng rồi tôi đọc tiếp và tìm được một nghiên cứu mà ít người nhắc đến. METR, một tổ chức research độc lập, vừa làm một randomized controlled trial với experienced open-source developers. Kết quả làm tôi khá shock: khi dùng AI tools, những developers này hoàn thành công việc chậm hơn 19% so với không dùng.

Phần thú vị hơn: sau experiment, chính những developers này tự đánh giá rằng họ đã nhanh hơn 20% nhờ AI. Họ sai hoàn toàn về productivity của chính mình.

Đây không phải câu chuyện về AI không work. Đây là câu chuyện về một thứ mà tôi thấy industry đang cố tình lờ đi: Verification Bottleneck.

TL;DR

- AI hiện viết 30%+ code tại Microsoft và Google, 41% trên toàn industry

- Productivity gain thực tế thấp hơn nhiều so với kỳ vọng do phải verify code

- 48% AI-generated code chứa potential security vulnerabilities

- 75% developers vẫn manually review từng dòng AI code trước khi merge

- Teams mất 15-25 percentage points productivity gains vào việc rework

Verification Bottleneck là cái gì?

Tôi hay giải thích thế này: hãy tưởng tượng bạn thuê một intern siêu năng suất. Anh ta code nhanh gấp 10 lần bạn, làm 24/7, không bao giờ complain. Sounds perfect?

Nhưng có một vấn đề: mỗi dòng code anh ta viết đều cần được review kỹ, vì khoảng một nửa chứa bugs hoặc security holes. Và người duy nhất có đủ context để review? Chính là bạn.

Đó chính xác là tình huống với AI coding assistants. AI generate code cực nhanh, nhưng tốc độ review của con người vẫn giữ nguyên. Bottleneck không còn ở việc viết code nữa, mà đã shift sang việc verify code.

Và đây là điều mà không conference talk nào về "AI productivity" muốn thừa nhận.

Những con số tôi tìm được

Tôi đào sâu thêm và tìm được báo cáo của CodeRabbit so sánh AI-generated code với human code. Kết quả khiến tôi phải suy nghĩ lại workflow của mình:

| Loại vấn đề | AI so với Human |

|---|---|

| Logic và Correctness errors | Nhiều hơn 1.75 lần |

| Code quality và Maintainability | Nhiều hơn 1.64 lần |

| Security findings | Nhiều hơn 1.57 lần |

| Performance issues | Nhiều hơn 1.42 lần |

Một study từ Stanford thì cho thấy teams phải dành thời gian đáng kể để rework AI code, "ăn" mất 15-25 percentage points từ productivity gains ban đầu. Nếu bạn expect AI giúp tăng 30-40% productivity, sau khi trừ rework, thực tế chỉ còn 5-15%.

Nhưng con số đáng lo nhất: 75% developers cho biết họ vẫn manually review từng snippet AI generate trước khi merge. Nghĩa là review time tăng tỷ lệ thuận với output của AI. Senior developers thực tế đang dành nhiều thời gian hơn cho review so với thời pre-AI.

Chuyện của một đồng nghiệp tôi

Để cho dễ hình dung, tôi kể chuyện của Minh, một senior dev tôi quen ở một startup fintech. Anh được giao task implement payment validation module.

Với Copilot, Minh generate được ~500 dòng code trong một giờ. Anh nghĩ productivity tuyệt vời.

Rồi anh bắt đầu review. Phát hiện AI dùng string concatenation cho SQL queries thay vì parameterized queries - một lỗ hổng SQL injection cơ bản. Tiếp tục review, tìm thấy race condition trong logic concurrent transactions. Rồi một edge case khi amount là số âm không được handle.

Tổng thời gian review và fix: hơn 2 giờ. Viết tests và verify: thêm 1 giờ. Tổng: ~4 giờ cho 500 dòng code.

Nếu Minh viết từ đầu theo cách truyền thống? Với kinh nghiệm của anh, khoảng 3 giờ, và code sẽ đúng ngay từ đầu vì anh hiểu context của payment system.

Đây không phải edge case. Đây là reality mà nhiều experienced devs đang trải qua hàng ngày.

48% AI Code chứa Security Vulnerabilities

Nếu verification bottleneck chỉ ảnh hưởng productivity, có lẽ tôi chấp nhận được. Nhưng khi đọc về security, tôi bắt đầu lo thật sự.

Một study phân tích 100+ LLMs trên 80 coding tasks cho thấy: chỉ 55% AI-generated code là secure. Gần một nửa code AI viết chứa known vulnerabilities ngay từ lúc generate. Và đây là code đang được deploy vào production của hàng ngàn công ty.

Nếu bạn quan tâm đến cách AI có thể giúp phân tích vulnerabilities thay vì tạo ra chúng, có thể tham khảo bài viết về LLM-powered vulnerability analysis.

Những lỗ hổng tôi thấy xuất hiện nhiều nhất

Improper Password Handling - AI hay suggest lưu password plaintext, dùng MD5/SHA1, hoặc skip salt. Cơ bản nhưng xuất hiện với tần suất đáng lo.

Injection Vulnerabilities - SQL injection từ string concatenation, command injection, XSS. AI train trên massive codebases, và đáng tiếc một phần không nhỏ chứa vulnerable code. Models học cả patterns tốt lẫn xấu.

Hallucinated Dependencies - Đây là attack vector mới tôi mới biết năm nay. AI đôi khi suggest packages không tồn tại. Attackers đã nhận ra và bắt đầu register malicious packages với những tên AI hay suggest. Một biến thể của dependency confusion attack.

Excessive I/O Operations - Theo CodeRabbit, AI code có I/O issues nhiều hơn ~8 lần so với human code. Tạo DoS vectors, race conditions, resource exhaustion.

Tại sao AI viết code không secure?

Tôi nghĩ có ba nguyên nhân chính:

Training Data Contamination - AI train trên public repos chứa cả secure và insecure code. Từ góc nhìn model, cả hai đều valid. Nó không có concept "đây là cách đúng" theo security standards.

Lack of Security Context - Khi bạn prompt AI viết login function, nó không biết gì về auth model của app bạn, trust boundaries, hay business logic. Nó chỉ generate dựa trên statistical patterns.

Recency Bias - Models train trên code từ nhiều năm trước. Security best practices thay đổi liên tục. AI có thể suggest library versions đã outdated hoặc patterns đã deprecated.

Một ví dụ tôi hay gặp

Đây là code AI generate khi được yêu cầu viết function lấy user:

# AI-generated code

def get_user(username):

query = f"SELECT * FROM users WHERE name = '{username}'"

return db.execute(query)

Nhìn qua thì OK, chạy đúng trong hầu hết cases. Nhưng input username là ' OR '1'='1' --? SQL injection điển hình.

Version đúng:

# Secure implementation

def get_user(username):

query = "SELECT * FROM users WHERE name = ?"

return db.execute(query, (username,))

Khác biệt chỉ vài characters, nhưng impact hoàn toàn khác. Đây là lý do verification không thể skip.

Workflow AI Code Review hiện tại đang broken

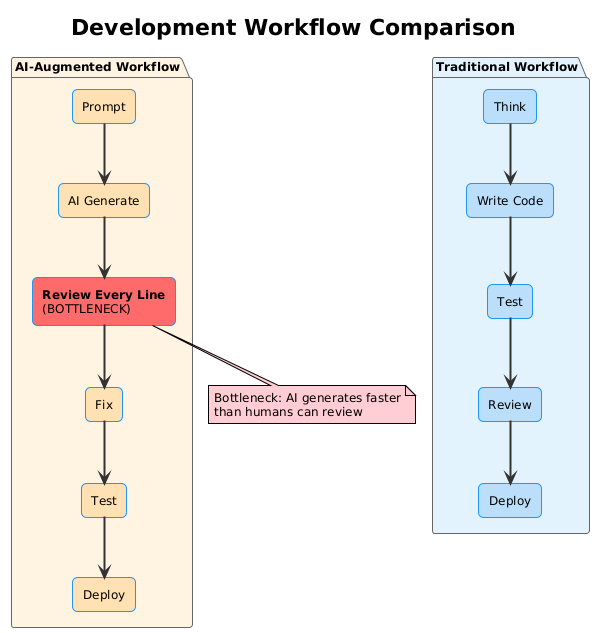

Để hiểu tại sao bottleneck này nghiêm trọng, tôi nhìn vào cách workflows đã thay đổi.

Traditional workflow: Think → Write Code → Test → Review → Deploy. Toàn bộ do human với full context. Thời gian phân bố tương đối đều.

So sánh workflow: Traditional (phải) vs AI-Augmented (trái). Bước "Review Every Line" trở thành bottleneck.

AI-augmented workflow: Prompt → AI Generate → Review Every Line → Fix → Test → Deploy. Trên lý thuyết, generate nhanh hơn. Thực tế, bottleneck chỉ shift sang review, và bước này không thể parallelize bằng AI.

Ba vấn đề tôi nhận ra

Review Fatigue - Khi AI generate nhanh hơn khả năng review của con người, developers bắt đầu review ít kỹ theo thời gian. Sau vài giờ review liên tục, chất lượng giảm. Đây là lúc critical bugs slip through.

Context Switching - Viết code truyền thống, bạn maintain context liên tục. Với AI, flow bị break: thinking → prompting → reviewing. Mỗi lần switch, một phần context mất. AI generate không có full context của bạn, nên code hay missing edge cases.

The "Almost Right" Problem - 66% developers cho biết frustration lớn nhất là solutions "gần đúng nhưng không hoàn toàn đúng". Code trông correct, passes initial review, nhưng fails ở edge cases. Debug code người khác viết (kể cả AI) thường tốn effort hơn viết từ đầu.

Workflow tôi đang thử

Thay vì review tất cả với cùng mức độ kỹ lưỡng, tôi đang thử phân tầng:

Hiểu vấn đề → Specify critical parts → AI generate boilerplate →

Review critical logic only → Automated security scan → Test

Ý tưởng: để AI làm những gì nó giỏi (boilerplate, patterns, standard implementations). Human focus vào những gì AI yếu (business logic, security, architecture). Automated tools làm force multiplier.

5 Giải pháp thực tế cho Verification Bottleneck

Nói vấn đề thì dễ, đưa giải pháp mới khó. Đây là 5 strategies tôi đang apply:

1. Tiered Review Strategy

Không phải tất cả code đều cần review cùng mức độ. Tôi phân thành 3 tiers:

Phân loại code theo risk level: Xanh (auto-approve), Vàng (quick scan), Đỏ (full review).

Tier 1: Auto-approve - Test files, docs, comments, config không liên quan security, standard CRUD cho internal tools. Risk thấp, bugs sẽ bị catch bởi tests hoặc không gây impact nghiêm trọng.

Tier 2: Quick scan - 30 giây đến 1 phút. Internal utilities, non-critical UI, code chỉ dùng dev/staging. Check logic flow, ensure không obvious issues.

Tier 3: Full review - Không exception. Auth/authz, data validation, crypto, external APIs, database queries, payment processing. Bug ở đây = data breach, financial loss, compliance violations.

2. Automated Security Gates

Manual review không scale. Tôi cần automated tools làm first line of defense.

Tools tôi integrate: Semgrep cho static analysis, Snyk cho dependency scanning (xem thêm về SBOM và dependency management), CodeQL cho GitHub, SonarQube cho quality gates.

Một ví dụ GitHub Actions workflow tôi dùng:

name: AI Code Security Check

on: [pull_request]

jobs:

security-scan:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v4

- name: Run Semgrep

run: |

pip install semgrep

semgrep --config=auto --error

- name: Check Dependencies

run: |

npm install -g snyk

snyk test --severity-threshold=high

Quan trọng: block merges nếu scans fail. Đừng chỉ warning rồi cho qua. Vulnerability phát hiện trước merge cheap hơn rất nhiều so với incident trong production.

3. Prompt Engineering for Security

Cách prompt ảnh hưởng trực tiếp đến quality và security của output.

Bad prompt:

"Write a login function"

AI sẽ generate generic function, có thể có hoặc không có proper security.

Good prompt:

"Write a login function with the following requirements:

- Use parameterized queries for database operations

- Hash passwords using bcrypt with cost factor 12

- Implement rate limiting: max 5 failed attempts per 15 minutes per IP

- Return generic error messages (don't reveal if username or password is wrong)

- Log failed attempts with timestamp and IP (but not the password)

- Use the existing auth.utils module for token generation"

Specify security requirements explicitly. Reference existing patterns. Mention cả những gì KHÔNG nên làm. AI vẫn có thể sai, nhưng probability thấp hơn nhiều.

4. The AI Buddy System

Đừng rely một tool duy nhất. Mỗi AI có strengths và weaknesses khác nhau. Tôi combine:

- Claude Code cho complex logic và reasoning tasks. Thường produce code "production-ready" hơn, ~30% less rework.

- GitHub Copilot cho boilerplate và fast iteration. IDE integration smooth, suggestion speed nhanh.

- Semgrep/Snyk cho automated security scanning. Non-negotiable trong pipeline.

- Human review chỉ cho critical paths và architectural decisions.

Dùng đúng tool cho đúng job.

5. Team Calibration

AI tools có behaviors khác nhau. Team cần calibrate expectations dựa trên actual data, không phải marketing claims.

Với teams: Share AI failure examples internally. Build "AI gotchas" list specific cho tech stack. Review AI code together ban đầu để calibrate chuẩn chung. Track metrics bugs từ AI code vs human code.

Với individuals: Theo dõi patterns lỗi AI của bạn hay mắc. Build personal checklist. Biết weaknesses của tools bạn dùng. Copilot thường weak error handling, Claude đôi khi over-engineer.

Tác động đến ngành và Vietnamese Tech

Verification bottleneck không chỉ là vấn đề technical. Nó đang reshape job market và career paths.

Junior Developer Crisis

Entry-level tech jobs đang giảm đáng lo. UK giảm 46% trong 2024, dự kiến 53% cuối 2026. US một số datasets cho thấy giảm tới 67%. Không phải layoffs, mà companies simply stop hiring juniors.

Harvard phát hiện sau khi AI coding tools phổ biến cuối 2022, companies adopting AI hire ít hơn 5 juniors mỗi quý. Hiring freeze, không phải layoffs.

Nhưng đây là paradox thú vị: verification bottleneck thực tế tạo ra role mới. Nếu 75% devs vẫn cần manually review AI code, và volume tăng, thì demand cho người review code quality cũng tăng. "AI Code Reviewer/AI Code Bug fixer ✌️" có thể là entry-level position hợp lệ.

The Talent Pipeline Paradox

Quote tôi hay nghĩ đến: "No juniors today means no senior engineers in 5-10 years."

Junior developers luôn là training ground cho future tech leaders. Họ học bằng cách làm, được review, make mistakes và learn. Nếu AI wipe out entry-level layer, chúng ta đang tạo skills gap nghiêm trọng cho tương lai.

Cơ hội cho Vietnamese Developers

Đây có thể là opportunity nếu nhìn đúng góc. Vietnamese devs có reputation về sự cẩn thận và detail-oriented. Đây chính xác là qualities cần cho verification roles.

Thay vì compete trên coding speed, một direction khác là positioning as quality guardians. Companies cần người review AI output, catch security issues, ensure code quality. Đây là skills AI không thể replace.

Skills cần develop: security mindset, code review expertise, understanding AI tool behaviors, khả năng communicate technical issues clearly.

Kết luận: Reality mới của Developer

Verification bottleneck không phải bug, mà là feature. Nó là safety mechanism giữ cho chúng ta honest về capabilities thực sự của AI.

Mindset Shifts tôi đang apply

Thứ nhất: Viết code không còn là phần khó. Reviewing, verifying, securing code mới là phần khó. Identity của developer cần shift từ "người viết code" sang "người đảm bảo code quality".

Thứ hai: AI là junior developer, không phải senior. Bạn có bao giờ merge PR của junior mới vào team mà không review? Tại sao treat AI code differently? Cùng rules apply: review, question assumptions, verify edge cases.

Thứ ba: Automated tooling là non-negotiable. Manual review không scale. Security scans trước mỗi merge là baseline. Quality gates là safety net.

Action Items

Tuần này: Audit process hiện tại với AI code. Review bao nhiêu? Quality như thế nào? Có automated scans chưa?

Tháng này: Implement tiered review strategy. Phân loại code theo risk level.

Quý này: Integrate automated security scanning vào CI/CD. Block merges on failures. Track metrics.

Long-term: Build team culture xung quanh AI output quality. Share learnings, calibrate expectations.

Lời cuối

Verification bottleneck sẽ không biến mất. Nó là natural consequence của việc AI generate code faster than humans can verify.

Teams figure out cách navigate này effectively sẽ 10x output. Teams ignore nó sẽ 10x technical debt.

Chọn phe nào là quyền của bạn.

FAQ: Câu hỏi thường gặp về Verification Bottleneck

Q: Verification Bottleneck là gì?

A: Verification Bottleneck là hiện tượng khi AI generate code nhanh hơn rất nhiều so với khả năng review của con người, khiến bước review trở thành điểm nghẽn (bottleneck) trong development workflow. Thay vì tăng productivity, điều này có thể làm chậm quá trình phát triển vì senior developers phải dành nhiều thời gian hơn để verify AI output.

Q: Bao nhiêu phần trăm AI code chứa security vulnerabilities?

A: Theo nghiên cứu phân tích 100+ LLMs trên 80 coding tasks, khoảng 45-48% AI-generated code chứa known security vulnerabilities. Các lỗi phổ biến bao gồm SQL injection, improper password handling, và hallucinated dependencies.

Q: Có nên ngừng sử dụng AI coding tools?

A: Không. AI coding tools vẫn hữu ích cho boilerplate code, repetitive patterns, và accelerate certain tasks. Vấn đề là cần có proper workflow: tiered review strategy, automated security scanning, và calibrated expectations về AI output quality.

Q: Tool nào tốt nhất để scan AI-generated code?

A: Không có "best" tool duy nhất. Recommend combine: Semgrep cho static analysis, Snyk cho dependency scanning, CodeQL nếu dùng GitHub. Quan trọng là integrate vào CI/CD và block merges khi scans fail.

References

- MIT Technology Review. Generative coding: 10 Breakthrough Technologies 2026. January 2026.

- METR. Measuring the Impact of Early-2025 AI on Experienced Open-Source Developer Productivity. July 2025.

- CodeRabbit. State of AI vs Human Code Generation Report. 2025.

- Georgetown CSET. Cybersecurity Risks of AI-Generated Code. November 2024.

- TechCrunch. Microsoft CEO says up to 30% of the company's code was written by AI. April 2025.

- Dark Reading. As Coders Adopt AI Agents, Security Pitfalls Lurk in 2026. January 2026.

- Stack Overflow. 2025 Developer Survey - AI Section. 2025.

- CIO. Demand for junior developers softens as AI takes over. 2025.

- Veracode. AI-Generated Code Security Risks: What Developers Must Know. 2025.

- GetPanto. AI Coding Assistant Statistics 2026. 2026.